Kurs:Statistik für Anwender/Binomialverteilte Zufallsvariable

Binomialverteilte ZV

Wahrscheinlichkeitsrechnung

Zufallsexperiment

Wir betrachten ein (wiederholbares) ZE, das -mal durchgeführt wird. Bei jeder Durchführung wird beobachtet, ob ein bestimmtes (vorher festgelegtes) Ereignis eintritt oder nicht. Abkürzend sagt man:

Wichtig ist dabei, dass die einzelnen Durchführungen

- unabhängig voneinander sind

- unter gleichen Bedingungen stattfinden

Zufallsvariable T

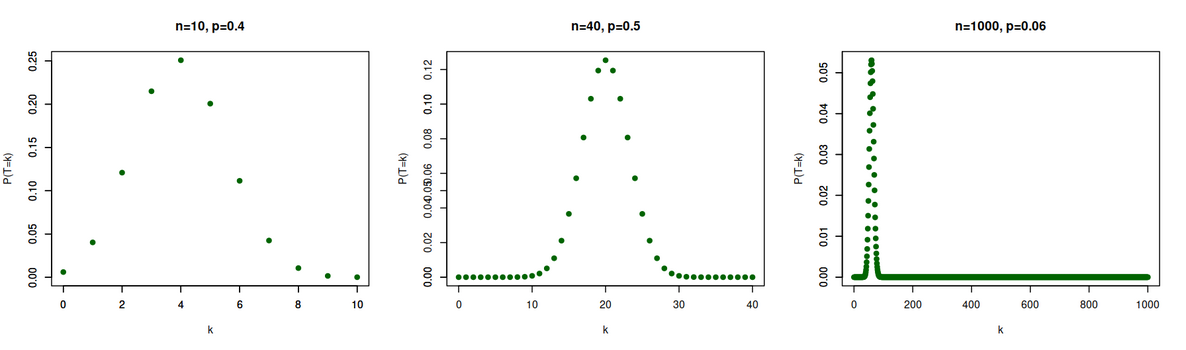

Man fasst den gesamten Vorgang nun als ein ZE auf. Die ZV , die die Anzahl der Treffer beschreibt, nennt man dann binomialverteilt mit Versuchszahl und Trefferwahrscheinlichkeit und es gilt:

Begründung

Dies lässt sich wie folgt begründen:

Für eine bestimmte Abfolge von Treffern und Nicht-Treffern ist die Wahrscheinlichkeit (entsprechend einem Pfad in einem Baumdiagramm) das Produkt aus -Faktoren, von denen Faktoren sind und Faktoren . Sie hat also den Wert .

Es gibt jedoch mehrere Pfade, in denen genau Treffer vorkommen. Da diese Treffer an von Stellen vorkommen können, sind es insgesamt Möglichkeiten.

Beispiel 1

Für und ist

Beispiel 2.1

Für und ist beispielsweise:

Wahrscheinlichkeiten

Beispiel 3

Für und ist beispielsweise:

Beispiel 4

Für und ist beispielsweise:

Beispiel 5

Hier einige weitere Beispiele:

Beispiel 6

Interaktive App zur Binomialverteilung:

In R

Aufgabe 1

Berechnen Sie für eine binomialverteilte ZV mit den jeweils angegebenen Werten für und die angegebenen Wahrscheinlichkeiten:

- Für und : für alle

- Für und :

- Für und :

Beispiele für Binomialverteilung 1

- (Ziehen mit Zurücklegen) Aus einer Lostrommel, die Kugeln enthält, von denen rot sind, werden nacheinander mit Zurücklegen Kugeln gezogen. Die ZV für die Anzahl roten Kugeln unter den Gezogenen ist binomialverteilt mit Versuchszahl und Trefferwahrscheinlichkeit .

- Wenn man -mal würfelt, ist die ZV für die Zahl der gewürfelten -en binomialverteilt mit Versuchszahl und Trefferwahrscheinlichkeit .

Beispiele für Binomialverteilung 2

- Wenn ein Medikament, das mit einer Wahrscheinlichkeit von eine bestimmte Nebenwirkung verursacht, von Patienten eingenommen wird, ist die ZV für die Zahl der Patienten, bei denen die Nebenwirkung auftritt, binomialverteilt mit Versuchszahl und Trefferwahrscheinlichkeit .

Beispiele für Binomialverteilung 3

- Wenn ein Basketballspieler Freiwürfe macht, ist die ZV für die Zahl seiner Treffer nur unter folgenden Annahmen binomialverteilt:

- Es gibt eine Trefferwahrscheinlichkeit , die immer gleich groß ist.

- Treffer bzw. Nicht-Treffer bei bestimmten Würfen beeinflussen nicht die Trefferwahrscheinlichkeit für die anderen Würfe.

Beispiele für Binomialverteilung 4

- Die Wahrscheinlichkeit für eine Mädchengeburt betrage . Unter Neugeborenen ist dann die ZV für die Zahl der Mädchen binomialverteilt mit Versuchszahl und Trefferwahrscheinlichkeit .

Beispiel Aufgaben 1

- Bei einem Multiple-Choice Test gibt es bei jeder der 20 Fragen 4 Antwortmöglichkeiten, von denen genau eine Antwort richtig ist. Ein unvorbereiteter Teilnehmer kreuzt willkürlich jeweils eine Antwort an. Wie groß ist die Wahrscheinlichkeit, dass er

richtig beantwortet? - Wie groß ist die Wahrscheinlichkeit beim 10-maligen Werfen von 2 Würfeln die Augensumme zu erzielen?

Beispiel Aufgaben 2

- Auf dem Weg zur Arbeit ist eine Ampel jeden Tag mit der Wahrscheinlichkeit rot. Berechnen Sie die Wahrscheinlichkeit, dass die Ampel an genau von 7 Tagen Rot ist .

- Ein Bäcker knetet in einen Teig für 100 Rosinenbrötchen 200 Rosinen gut unter. Dann wird der Teig in 100 gleiche Teile geschnitten. Mit welcher Wahrscheinlichkeit enthält ein rein zufällig ausgewähltes Brötchen dieser Charge

Rosinen?

Zusatzfrage: Wie viele Rosinen muss der Bäcker in den Teig für 100 Rosinenbrötchen kneten, damit ein auf gut Glück ausgewähltes Brötchen mit einer Mindestwahrscheinlichkeit von mindestens eine Rosine enthält?

Erwartungswert und Varianz einer binomialverteilten ZV

Für eine binomialverteilte ZV mit Versuchszahl und Trefferwahrsch. gilt:

EW und Varianz der relativen Häufigkeit

Ist eine binomialverteilte ZV mit Versuchszahl und Trefferwahrscheinlichkeit , so beschreibt die ZV die relative Häufigkeit des Ereignisses "Treffer" in der Versuchsserie.

Es gilt:

Beispiel 1

Für und haben wir oben bereits die Wahrscheinlichkeitsverteilung bestimmt. Daraus ergibt sich:

Tatsächlich ist und .

Beispiel 2.1

Für und berechnen wir zunächst für alle möglichen Werte :

Beispiel 2.2

Daraus ergibt sich:

Tatsächlich ist und .

Aufgabe 1

Sie werfen eine Münze 20 mal. Bestimmen Sie die folgenden Wahrscheinlichkeiten (Kopf ist "Treffer"):

Aufgabe 2

Bei dem Spiel Kniffel würfeln Sie mit fünf Würfeln (normalerweise bis zu dreimal, dies soll der Einfachheit wegen vernachlässigt werden). Wie hoch ist die Wahrscheinlichkeit,

- ein Kniffel (fünf Gleiche) zu würfeln.

- einen Vierer-Pasch (mindestens zwei Vierer) zu werfen.

Bestimmen Sie auch Erwartungswert und Varianz für das Werfen einer bestimmten Zahl.

Schätzungen für p

Problemstellung

Bisher können wir die Wahrscheinlichkeit dafür berechnen, dass die Trefferzahl in einem bestimmten Bereich liegt, wenn wir die Trefferwahrscheinlichkeit kennen. In der Praxis ist man häufig aber mit folgender Situation konfrontiert:

Unterscheidung

Genauer kann man unterscheiden:

- Die Versuchszahl steht fest und ist bekannt. (In vielen Fällen kann man sogar selbst festlegen.)

- Die Trefferwahrscheinlichkeit liegt fest, ist aber nicht bekannt.

- Die Trefferzahl ist zufällig.

Situation vor und nach der Datenerhebung

Sie wird vor Erhebung der Daten durch die ZV beschrieben. Nach der Datenerhebung liegt dann eine Realisierung der ZV vor.

Schätzungen für können nur auf der konkreten Realisierung (Trefferzahl) basieren. Da der Schätzung also die zufällige Trefferzahl zugrunde liegt, ist folglich auch die Schätzung vom Zufall abhängig.

Punktschätzung für p

Sei eine binomialverteilte ZV mit (bekannter) Versuchszahl und (unbekannter) Trefferwahrscheinlichkeit .

Eine Punktschätzfunktion für ist eine Abbildung:

Punktschätzfunktion vor und nach Datenerhebung

Eine solche Punktschätzfunktion kann aus verschiedenen Blickwinkeln betrachtet werden:

- Vor der Durchführung des ZE ist die Trefferzahl eine ZV. Da die Trefferzahl in die Schätzfunktion eingesetzt werden soll, kann man so auch die Schätzung selbst als ZV interpretieren.

- Nach dem Feststellen einer konkreten Trefferzahl kann man diese einfach in die Schätzfunktion einsetzen und erhält so in der Praxis eine konkrete Schätzung für .

Beispiel 1.1

(Relative Häufigkeit ist Punktschätzfunktion für ) Die Abbildung:

ist eine Punktschätzfunktion für .

Es stellt sich nun die Frage nach einer sinnvollen Punktschätzfunktion für (es liegt nahe, die relative Häufigkeit aus Beispiel Beispiel 1.1 zu betrachten) bzw. allgemeiner was überhaupt sinnvolle Eigenschaften für eine solche Schätzfunktion sind. Um dies zu beurteilen, sollte man den Standpunkt vor der Datenerhebung einnehmen.

Relative Häufigkeit als Zufallsvariable

Die relative Häufigkeit ist erwartungstreu, effizient und konsistent:

Fasst man die relative Häufigkeit als Zufallsvariable auf, so gilt:

- ist erwartungstreu für , das heißt es gilt: für alle

Dabei ist der (von abhängige) EW von . - Es gilt: für alle

Dabei ist die (von abhängige) Varianz von . - ist konsistent, das heißt für alle und alle gilt:

Dabei bedeutet das die Wahrscheinlichkeit in Abhängigkeit von berechnet wurde.

Das Maximum-Likelihood-Prinzip

Neben den schon genannten Qualitätskriterien für Punktschätzfunktionen (Erwartungstreue, Effizienz und Konsistenz) gibt es noch einen anderen Zugang, die sogenannte Maximum-Likelihood-Methode. Dabei wird für den unbekannten Parameter (hier die Trefferwahrscheinlichkeit ) der Wert geschätzt, für den die beobachteten Daten (hier die Trefferzahl ) möglichst wahrscheinlich waren.

Maximum-Likelihood-Schätzung 1

Die Maximum-Likelihood-Schätzung ist also wie folgt definiert:

Für ist die (globale) Maximumstelle der Funktion

( steht für Likelihood-Funktion)

Maximum-Likelihood-Schätzung 2

Die Wahrscheinlichkeit wird bei Treffern in Versuchen also als der Wert geschätzt, für den die Wahrscheinlichkeit für genau Treffer maximal ist.

Man kann zeigen, (vergleiche die folgenden Beispiele) dass stets gilt. Auch mit dieser Methode erhält man also die relative Häufigkeit als sinnvolle Schätzung für .

Beispiel 2

n = 50, k =10 bzw. n=400, k = 250

Intervallschätzungen für p

Ein (für die Praxis relevantes) Problem bei den bisher behandelten Punktschätzungen für ist, dass es sich bei den Gütekriterien (Erwartungstreue, Effizienz und Konsistenz) für die Schätzfunktionen lediglich um qualitative Aussagen handelt.

Ziel ist es nun, Schätzungen für zu formulieren, die man auch quantitativ beurteilen kann. Eine solche hat die Form:

Situation

Wir betrachten die folgende Situation:

Zu einer binomialverteilten ZV ist die Versuchszahl fest und bekannt und die Trefferwahrscheinlichkeit fest, aber unbekannt. Basierend auf der vom Zufall abhängigen Trefferzahl soll nun eine Intervallschätzung

für vorgenommen werden.

Betrachtung vor der Datenerhebung

Erneut nehmen wir die folgenden beiden Standpunkte ein:

Vor der Durchführung des ZE ist die Trefferzahl eine ZV. Da die Trefferzahl in die Intervallschätzfunktion eingesetzt werden soll, hängt somit auch das berechnete Intervall

vom Zufall ab. Damit ist es auch vom Zufall abhängig, ob die resultierende Aussage

wahr oder falsch sein wird.

Betrachtung nach der Datenerhebung

Nach dem Feststellen einer konkreten Trefferzahl kann man diese einfach in die Schätzfunktion einsetzen und erhält so in der Praxis eine konkrete Intervallschätzung

für . Die Aussage

ist dann nicht mehr vom Zufall abhängig, sondern entweder wahr oder falsch. (Leider weiß man nicht, welcher der beiden Fälle eingetreten ist, da man nicht kennt.)

Intervallschätzung als Abbildung

Sei die Menge der abgeschlossenen Teilintervalle von .

Eine Intervallschätzung (bzw. Bereichsschätzung) für ist eine Abbildung:

Beurteilung einer Intervallschätzung

Um Intervallschätzungen sinnvoll beurteilen zu können, untersuchen wir die (vom unbekannten Parameter abhängige) Wahrscheinlichkeit dafür, dass man ein "korrektes Intervall" (also eines, dass tatsächlich enthält) berechnet, wenn man die (vom Zufall abhängige) Trefferzahl einsetzt.

Überdeckungswahrscheinlichkeit und Konfidenzniveau

Gegeben sei eine Intervallschätzfunktion:

Überdeckungswahrscheinlichkeit

Für einen denkbaren Parameterwert definiert man die Überdeckungswahr-scheinlichkeit von an der Stelle durch:

Anmerkung

Die Schreibweise ist mathematisch gleichbedeutend zu , hat aber den Vorteil, dass dabei deutlich wird, dass (und nicht ) vom Zufall abhängt. Anstatt zu sagen: ist in enthalten." formuliert man daher auch fängt ein."

Konfidenzniveau

Gilt für eine feste Zahl , so sagt man auch:

"Die Intervallschätzung hält das Konfidenzniveau ein."

Bedeutung 1

Die Überdeckungswahrscheinlichkeit entspricht der Wahrscheinlichkeit dafür, dass man ein korrektes Intervall erhalten wird, wenn man die zufällige Trefferzahl in die Intervallschätzung einsetzt. Da die Überdeckungswahrscheinlichkeit vom unbekannten Parameter abhängt, kann man sie in der Praxis nicht berechnen.

Bedeutung 2

Weiß man aber (aufgrund theoretischer Überlegungen), dass eine Intervallschätzung ein bestimmtes Konfidenzniveau einhält, so ist (unabhängig vom wahren Wert von ) garantiert, dass man MINDESTENS mit der Wahrscheinlichkeit ein korrektes Intervall erhalten wird, wenn man die zufällige Trefferzahl in die Intervallschätzung einsetzt.

In der Praxis sollte man nur Intervallschätzungen verwenden, von denen man weiß, dass sie ein hohes Konfidenzniveau (üblich sind oder oder ) einhalten.

Ziel

Wie findet man zu einem vorgegebenen Konfidenzniveau eine Intervallschätzung, die dieses Konfidenzniveau garantiert einhält.

Intervallschätzung nach Clopper-Pearson

Vorgegeben sei .

Für bestimmt man und aus den Gleichungen:

Dann hält die Intervallschätzung garantiert das Konfidenzniveau ein.

Ausnahmen

Ausnahme sind folgende Sonderfälle:

Für setze , für setze .

Anmerkung

Obige Bestimmungsgleichungen für und sind ohne Computereinsatz kaum zu lösen. Konfidenzintervalle nach Clopper-Pearson können aber in R direkt berechnet werden. Der Befehl

ergibt das Konfidenzintervall zum Vertrauensniveau bei Treffern in Versuchen.

Bemerkung 1

Obergrenzen für die Wahrsch. für Über- bzw. Unterschätzung von :

Die Grenzen und der Intervallschätzung nach Clopper-Pearson aus Satz Intervallschätzung nach Clopper-Pearson sind so gewählt, dass die Wahrscheinlichkeiten für "Unterschätzung" und "Überschätzung" von durch dieselbe Grenze beschränkt sind. Genauer:

Bemerkung 2

Zusammen ergibt sich damit

und folglich

Dass man diesen Aussagen überhaupt eine Wahrscheinlichkeit zuschreiben kann, liegt daran dass die Intervallgrenzen und zufällig sind (und nicht etwa der unbekannte, aber feste Wert ).

Beispiel 1.1

Für und ergeben sich die Intervallgrenzen als Lösungen der Gleichung

und

Beispiel 1.2

Hierbei wären also Polynome vom Grad

aufzulösen. Mit R berechnen wir:

Beispiel 2.1

Für erhält man zum Konfidenzniveau mit der Clopper-Pearson-Methode abhängig von die folgenden (mit R berechneten) Konfidenzintervalle :

Beispiel 2.2

Wir berechnen für verschiedene denkbare Werte von , die Überdeckungswahrscheinlichkeit (also die Wahrscheinlichkeit dafür, dass die Intervallschätzung korrekt ist):

Beispiel 2.3

Angenommen, es ist . Dann ist die Intervallschätzung für korrekt. Die Wahrscheinlichkeit dafür ist:

Beispiel 2.4

Angenommen, es ist . Dann ist die Intervallschätzung für korrekt. Die Wahrscheinlichkeit dafür ist:

Beispiel 2.5

Angenommen, es ist . Dann ist die Intervallschätzung für korrekt. Die Wahrscheinlichkeit dafür ist:

Beispiel 2.6

Angenommen, es ist . Dann ist die Intervallschätzung für korrekt. Die Wahrscheinlichkeit dafür ist:

Korrektheit der Schätzung

Es ist bewiesen, dass die Schätzung bei beliebigem immer mindestens mit der Wahrscheinlichkeit korrekt ist.

Größe der Konfidenzintervalle 1

Bei fester relativer Häufigkeit werden die Konfidenzintervalle mit wachsender Versuchszahl kleiner (mit mehr Versuchen erreicht man eine höhere Genauigkeit) und mit wachsendem Konfidenzniveau größer (ein höheres Konfidenzniveau "bezahlt"man mit einer ungenaueren Aussage). Man beachte die Größenordnungen dieser Veränderungen anhand der folgenden (mit R berechneten) Konfidenzintervalle:

Größe der Konfidenzintervalle 2

Bemerkung Verwendung von Intervallschätzungen in der Praxis 1

In der Praxis ist bei der Verwendung von Intervallschätzungen wie folgt vorzugehen:

1. Zunächst macht man sich die Situation klar: Die Trefferwahrscheinlichkeit einer Binomialverteilung ist unbekannt (aber fest, d.h. nicht vom Zufall abhängig).

2. Man legt fest:

- das Verfahren, mit dem man die Intervallschätzung berechnen wird. (z.B. zweiseitiger Test nach Clopper-Pearson).

Bemerkung Verwendung von Intervallschätzungen in der Praxis 2

- eine Versuchszahl

zu beachten:

Hohe Werte von führen zu einem engeren Konfidenzintervall. - ein Konfidenzniveau

zu beachten:

Hohe Werte von entsprechen einer höheren Untergrenze für die Wahrscheinlichkeit einer korrekten Schätzung, führen aber zu einem breiteren Konfidenzintervall. Sinnvoll ist z.B. .

Bemerkung Verwendung von Intervallschätzungen in der Praxis 3

3. Man führt die Versuchsreihe durch und stellt die Trefferzahl fest.

Zu beachten:

Wichtig bei einer Binomialverteilung ist, dass die einzelnen Versuche unabhängig voneinander und immer unter den gleichen Bedingungen durchgeführt werden.

Bemerkung Verwendung von Intervallschätzungen in der Praxis 4

4. Man berechnet das Konfidenzintervall mit der zuvor festgelegten Methode. (Dies kann der Computer erledigen.)

5. Man verkündet das Ergebnis:

" Das Konfidenzniveau

wurde eingehalten." Damit ist klar: Vor Erhebung der Daten war die Wahrscheinlichkeit ein korrektes Intervall zu erhalten, mindestens

. Nach Berechnung des Intervalls kann man damit der Aussage

ein gewisses Vertrauen entgegenbringen (aber keine Wahrscheinlichkeit zuweisen, sie ist entweder wahr oder falsch).

Bemerkung Einseitig begrenzte Konfidenzintervalle

In gewissen Situationen kann es Sinn machen, die Clopper-Pearson-Methode so zu modifizieren, dass man einseitig (statt wie bisher zweiseitig) begrenzte Konfidenzintervalle berechnet.

Beispiel 3

Ist beispielsweise die Wahrscheinlichkeit dafür, dass eine bestimmte Maßnahme einen gewünschten Erfolg erzielt, so könnte es wichtig sein, (möglichst strikt) nach unten abzuschätzen, aber eine Abschätzung von nach oben ist nicht notwendig.

Dazu kann man linkssseitig begrenzte Konfidenzintervalle verwenden.

Beispiel 4

Ist beispielsweise die Wahrscheinlichkeit dafür, dass bei der Einnahme eines Medikaments eine (unerwünschte) Nebenwirkung auftritt, so könnte es wichtig sein, (möglichst strikt) nach oben abzuschätzen, aber eine Abschätzung von nach unten ist nicht notwendig.

Dazu kann man rechtsseitig begrenzte Konfidenzintervalle verwenden.

Einseitig begrenze Konfidenzintervalle

Einseitig begrenze Konfidenzintervalle zu einem vorgegebenen Konfidenzniveau werden wie folgt berechnet:

Linksseitig begrenzte Konfidenzintervalle

Bei Treffern aus Versuchen bestimmt man das linksseitig begrenzte Konfidenzintervall zum Vertrauensniveau durch

(Sonderfall: Für setze .)

Rechtsseitig begrenzte Konfidenzintervalle

Bei Treffern aus Versuchen bestimmt man das rechtsseitig begrenzte Konfidenzintervall zum Vertrauensniveau durch

(Sonderfall: Für setze .)

Überschätzung bei linksseitig begrenzten Konfidenzintervallen

Linksseitig begrenzte Konfidenzintervalle dürfen den Wert von mit einer Wahrscheinlichkeit von bis zu überschätzen (statt wie bei den zweiseitigen Intervallschätzungen). Um dies auszugleichen, unterschätzen sie den Wert von nie (die obere Grenze ist ). Die untere Grenze kann daher im Vergleich zum zweiseitigen Test etwas besser (größer) gewählt werden.

Unterschätzung bei rechtsseitig begrenzten Konfidenzintervallen

Rechtsseitig begrenzte Konfidenzintervalle dürfen den Wert von mit einer Wahrscheinlichkeit von bis zu unterschätzen (statt wie bei den zweiseitigen Intervallschätzungen). Um dies auszugleichen, überschätzen sie den Wert von nie (die untere Grenze ist ). Die obere Grenze kann daher im Vergleich zum zweiseitigen Test etwas besser (kleiner) gewählt werden.

Berechnung in R

In R berechnet man einseitige Konfidenzintervalle nach Clopper-Pearson mit

" "

" "

Beispiel 5

Konfidenzintervalle im Vergleich für :

Bestimmung der Intervallgrenzen

Allgemein bestimmt man aus den Gleichungen die Grenzen einer Intervallschätzung , die den Wert von mit einer Wahrscheinlichkeit von höchstens überschätzt und mit einer Wahrscheinlichkeit von höchstens unterschätzt.

Konfidenzniveau der Schätzung

Das heißt, es gilt

und damit

Damit ist das Konfidenzniveau der Schätzung.

Beispiel 6

Für hat man zum Beispiel folgende Möglichkeiten:

Aufgabe 3.1

Bei einer bestimmten Tierart kann bei bestimmten Nachkommen eine morphologische Veränderung beobachtet werden. Die genaue Wahrscheinlichkeit dafür, dass ein neugeborenes Tier die morphologische Veränderung aufweisst, ist aber unbekannt und soll geschätzt werden.

In einer Studie werden dazu neugeborene Tiere untersucht. Von diesen Tieren weissen die morphologische Veränderung auf.

Aufgabe 3.2

1. Geben Sie anhand der Daten eine Punktschätzung für ab.

2. Stellen Sie die Maximum-Likelihood-Funktion auf

3. Es soll eine Intervallschätzung für zum Konfidenzniveau abgegeben werden.

- Geben Sie die Gleichungen an, anhand derer sich und bestimmen lassen (zweiseitige Intervallschätzung nach Clopper-Pearson). Verwenden Sie dazu wieder die erhobenen Daten ( Nachkommen mit morphologischer Veränderung bei untersuchten). Setzen Sie alle bekannten Zahlenwerte in die Gleichungen ein.

Aufgabe 3.3

- Berechnen Sie mit R die Grenzen und .

- Erklären Sie, inwiefern die Korrektheit der Intervallschätzung vom Zufall abhängt. Was weiß man über die Wahrscheinlichkeit, dass die Intervallschätzung korrekt ist? Unterscheiden Sie bei Ihren Erläuterungen die Situation vor und nach der Datenerhebung (bzw. der Berechnung der Intervallgrenzen).

Aufgabe 3.4

- Wie ändert sich die Breite des Konfidenzintervalls, wenn man das Konfidenzniveau von auf erhöht?

- Wie verändert sich die Breite des Konfidenzintervalls, wenn man statt morphologisch auffälligen von untersuchten neugeborenen Tieren eine Untersuchung mit von untersuchten neugeborenen Tieren zugrunde legt?

Seiteninformation

Diese Lernresource können Sie als Wiki2Reveal-Foliensatz darstellen.

Wiki2Reveal

Dieser Wiki2Reveal Foliensatz wurde für den Lerneinheit Kurs:Statistik für Anwender' erstellt der Link für die Wiki2Reveal-Folien wurde mit dem Wiki2Reveal-Linkgenerator erstellt.

- Die Seite wurde als Dokumententyp PanDocElectron-SLIDE erstellt.

- Link zur Quelle in Wikiversity: https://de.wikiversity.org/wiki/Kurs:Statistik%20f%C3%BCr%20Anwender/Binomialverteilte%20Zufallsvariable

- siehe auch weitere Informationen zu Wiki2Reveal und unter Wiki2Reveal-Linkgenerator.